Tutto queIlo che bisogna sapere sulle esibizioni delle Veline realizzate con Stable diffusion, piattaforma in grado di generare immagini e video partendo dal materiale che le viene fornito. A svelare i segreti del making of Francesco Angeli, che insieme a Paolo Alberti ha creato quello che avete visto in tv.

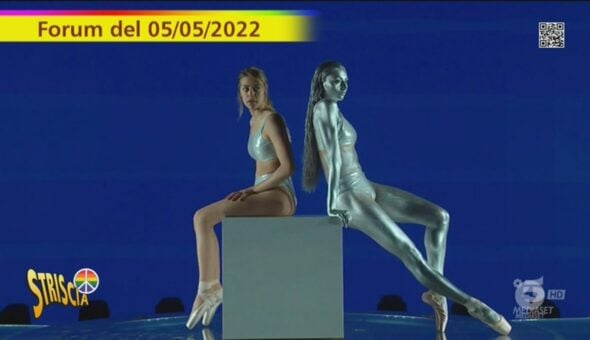

«La piattaforma utilizzata per realizzarli si chiama Stable diffusion, un’intelligenza artificiale generativa. Ci abbiamo lavorato due settimane», ha raccontato alla redazione di Striscia la notizia Francesco Angeli, creatore insieme a Paolo Alberti dello stacchetto in cui le Veline si trasformano in anime giapponesi. Andata in onda la sera del 25 settembre, nella puntata del 26 l’esibizione vede Anastasia e Cosmary diventare avatar in 3D.

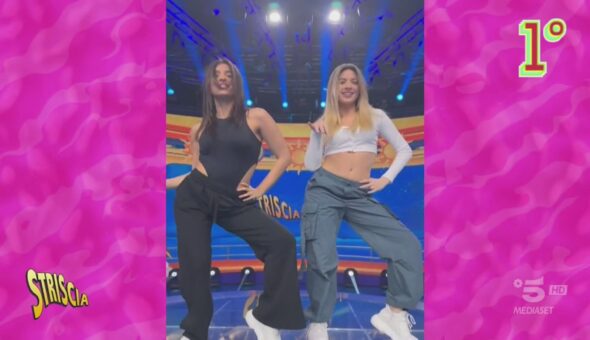

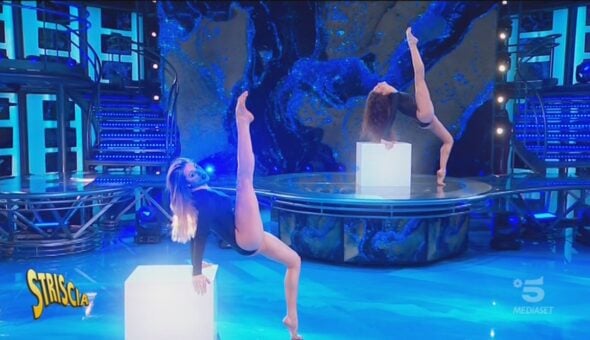

Angeli e Alberti hanno iniziato a lavorare con questo tipo di IA già nel 2022. «È un lavoro che si fa piano piano e si aggiusta il tiro man mano che la macchina lavora», ha spiegato il primo a proposito del procedimento per realizzare lo stacchetto. La tecnica permette di creare immagini e video a partire da contenuti di partenza forniti a Stable diffusion:«Come prima cosa abbiamo fatto dei test su alcuni vecchi balletti per vedere cosa funzionava e cosa no, volevamo sapere quali elementi distraevano troppo l’intelligenza artificiale». Lo step successivo è stato «girare un video in studio della performance delle Veline, con caratteristiche pensate ad hoc per agevolare l’IA nel suo compito. Per esempio, se gli avessi mostrato le persone troppo piccole avrebbe potuto non capire cosa si trovava di fronte o confondersi».

Come l’IA ha generato lo stacchetto delle Veline

Il passaggio successivo è stato scrivere i comandi per la macchina (il cui termine tecnico è prompt), cioè la descrizione del prodotto finale che si voleva. Sulla base di queste istruzioni, la IA ha elaborato la richiesta e realizzato il video. «C’è poi stata una piccola parte di post-produzione», ha precisato Angeli, «per rendere tutto più fluido e gradevole. Abbiamo lavorato sulla color correction, riducendo il contrasto del colore da un fotogramma all’altro e abbiamo usato i blur per ammorbidire l’immagine». Nessun intoppo durante la realizzazione? «C’era un vestito che la piattaforma non vedeva come un capo d’abbigliamento, non lo riconosceva. Pensava che fosse un promontorio di montagna su una persona. Abbiamo dovuto trovare un modo per spiegare alla macchina che cosa fosse in realtà».